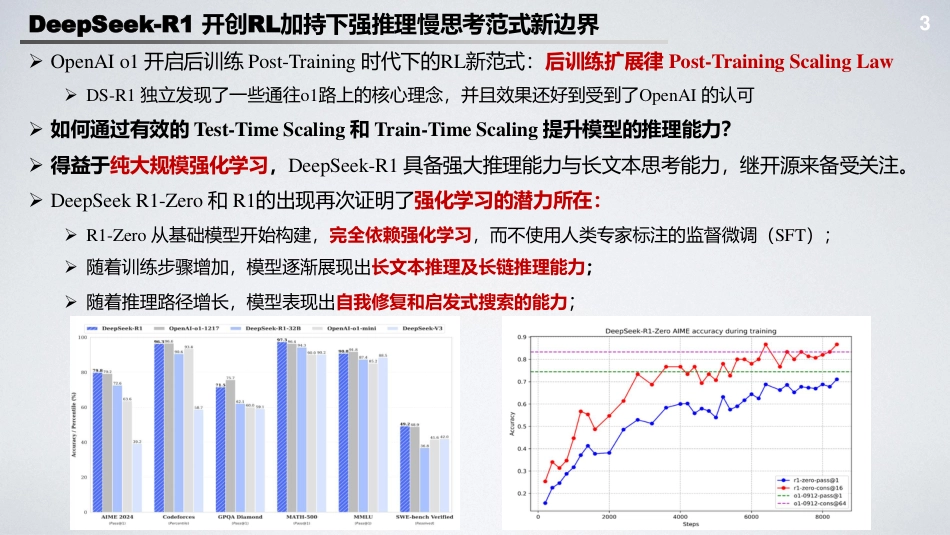

DeepSeek-R1\Kimi1.5及类强推理模型开发解读北大对齐小组陈博远北京大学2022级“通班”主要研究方向:大语言模型对齐与可扩展监督https://cby-pku.github.io/https://pair-lab.com/2Outline➢DeepSeek-R1开创RL加持下强推理慢思考范式新边界➢DeepSeek-R1Zero及R1技术剖析➢Pipeline总览\DeepSeek-V3Base\DeepSeek-R1Zero及R1细节分析➢RL算法的创新:GRPO及其技术细节➢DeepSeek-R1背后的Insights&Takeaways:RL加持下的长度泛化\推理范式的涌现➢DeepSeek-R1社会及经济效益➢技术对比探讨➢STaR-basedMethodsvs.RL-basedMethods强推理路径对比(DS-R1\Kimi-1.5\o-series)➢蒸馏vs.强化学习驱动:国内外现有各家技术路线对比分析及Takeaways➢PRM&MCTS的作用➢从文本模态到多模态➢其他讨论:Over-Thinking过度思考等➢未来方向分析探讨➢模态穿透赋能推理边界拓展:Align-DS-V➢合成数据及Test-TimeScaling:突破数据再生产陷阱➢强推理下的安全:形式化验证FormalVerification\审计对齐DeliberativeAlignment➢补充拓展:DeepSeek-V3解读3DeepSeek-R1开创RL加持下强推理慢思考范式新边界➢OpenAIo1开启后训练Post-Training时代下的RL新范式:后训练扩展律Post-TrainingScalingLaw➢DS-R1独立发现了一些通往o1路上的核心理念,并且效果还好到受到了OpenAI的认可➢如何通过有效的Test-TimeScaling和Train-TimeScaling提升模型的推理能力?➢得益于纯大规模强化学习,DeepSeek-R1具备强大推理能力与长文本思考能力,继开源来备受关注。➢DeepSeekR1-Zero和R1的出现再次证明了强化学习的潜力所在:➢R1-Zero从基础模型开始构建,完全依赖强化学习,而不使用人类专家标注的监督微调(SFT);➢随着训练步骤增加,模型逐渐展现出长文本推理及长链推理能力;➢随着推理路径增长,模型表现出自我修复和启发式搜索的能力;4DeepSeek-R1开创RL加持下强推理慢思考范式新边界➢得益于强大的推理能力与长文本思考能力,DeepSeekR1在复杂任务上表现卓越,成为开源领域的又一里程碑,标志着开源社区在与闭源大模型(如OpenAIo1系列)的竞争中迈出了关键性一步。➢DeepSeek-R1在数学代码任务上表现突出➢DeepseekR1在AIME2024上获得了79.8%的成绩,略高于OpenAI-o1-1217。在MATH-500上,获得97.3%的惊人成绩,表现与OpenAI-o1-1217相当。➢在编码相关的任务中表现出专家水平,在Codeforces上获得了2029Elo评级,在竞赛中表现优于96.3%的人类参与者➢DeepSeek-R1在知识类问答上推动科学探索边界:➢MMLU\MMLU-Pro\GPQADiamond等STEM-related榜单上取得良好表现➢R1展现出强推理模型在AI-DrivenResearch的潜力➢在长文本依赖任务如FRAMEs和事实性推断任务Simple-QA上表现突出5回顾:Pre-TrainingScalingLaw➢Pre-TrainingScalingLaws:预训练模型上广泛观察到的现象,协调了计算量C、模型参数量N和数据大小D之间的关系6回顾:Post-TrainingScalingLaw➢Post-Training阶段,随着训练时计算量(来自RL的Training阶段)和Test-Time计算量(例如Test-TimeSearch)的增长,模型性能(例如数学推理能力)也会随之提升➢Post-TrainingScalingLaws下训练时计算量多了一个新的变量:Self-Play探索时LLMInference的计算量[1]https://openai.com/index/learning-to-reason-with-llms/7回顾:Post-TrainingScalingLaw为什么我们需要后训练Scaling-Law?➢随着模型尺寸逐渐增大,预训练阶段参数ScalingUp带来的边际收益开始递减;如果想要深度提升模型推理能力和长程问题能力,基于RL的Post-Training将会成为下一个突破点。➢自回归模型在数学推理问题上很难进步的一点在于没有办法进行回答的自主修正,如果仅是依靠生成式方法和扩大参数规模,那么在数学推理任务上带来的收益不会太大。所以需要寻找额外的ScalingLaws[1]。[1]TrainingVerifierstoSolveMathWordProblemshttps://arxiv.org/pdf/2110.14168[2]ScalingLLMTest-TimeComputeOptimallycanbeMoreEffectivethanScalingModelParameters8DeepSeek-R1技术剖析:DeepSeek-R1ZeroDeepSeek-R1Zero:无需监督微调SFT,纯强化学习驱动的强推理模型DeepSeek-v3-Base(67...

VIP

VIP VIP

VIP VIP

VIP VIP

VIP VIP

VIP VIP

VIP VIP

VIP VIP

VIP VIP

VIP VIP

VIP